一篇新的研究论文显示,苹果公司对其他公司似乎忽视的人工智能技术问题有切实可行的解决方案,特别是如何在 iPhone 这样的低内存设备上使用大规模的大型语言模块。

尽管有人说苹果在生成式人工智能方面落后于业界,但该公司现在已经两次透露,它正在继续进行更长远的规划,而不是争先恐后地发布克隆版 ChatGPT。第一个迹象是一篇研究论文,其中提出了一种名为 HUGS 的人工智能系统,可以生成人类的数字化身。

现在,VentureBeat 又发现了第二篇研究论文,提出了在 iPhone 等内存有限的设备上部署大型语言模块(LLM)的解决方案。

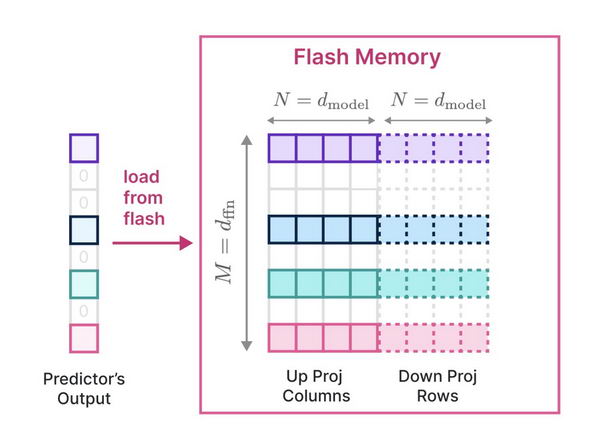

新论文名为 "LLM in a flash: Efficient Large Language Model Inference with Limited Memory"。苹果公司表示:"它通过将模型参数存储在闪存中,并根据需要将其带入 DRAM,解决了高效运行超过 DRAM 可用容量的 LLM 的难题"。

因此,整个 LLM 仍然需要存储在设备上,但可以通过将闪存作为一种虚拟内存来处理 RAM 中的 LLM,这与 macOS 处理内存密集型任务的方式并无二致。

研究论文称:"在这个闪存知情框架内,我们引入了两种主要技术。"首先,'窗口化' 通过重复使用先前激活的神经元,战略性地减少了数据传输......其次,'行列捆绑'针对闪存的顺序数据访问优势,增加了从闪存读取数据块的大小。"

这最终意味着,几乎任何大小的 LLM 都可以部署在内存或存储空间有限的设备上。这意味着苹果可以在更多设备上利用人工智能功能,从而以更多方式利用人工智能功能。

研究论文称:"我们研究的实际成果值得一提。我们已经展示了运行 LLM 的能力,其大小可达可用 DRAM 的两倍,推理速度比 CPU 中的传统加载方法提高了 4-5 倍,比 GPU 中的传统加载方法提高了 20-25 倍"。

"这一突破对于在资源有限的环境中部署先进的 LLM 尤为重要,"它继续说道,"从而扩大了它们的适用性和可访问性。"

苹果公司公开了这项研究,就像公开 HUGS 论文一样。因此,它不仅没有落后,反而正在努力提高整个行业的人工智能能力。

这与分析师的观点不谋而合,鉴于苹果公司的用户基础,分析师认为随着人工智能进一步成为主流,苹果公司将受益最大。

![[WIN] Win11 Tweaker v2.0.0](https://www.pcsofter.com/wp-content/uploads/2025/03/202503041623361.webp)

![[WIN] HDCleaner v2.088 中文多语言版](https://www.pcsofter.com/wp-content/uploads/2024/07/2024072216273939.webp)

![微软发布了 Windows 11 原生 Copilot 应用 [附安装方法]](https://www.pcsofter.com/wp-content/uploads/2025/03/2025030417534785.webp)