人工智能聊天机器人最令人诟病的行为之一就是所谓的 "幻觉",即人工智能在令人信服地回答问题的同时,却向你提供了与事实不符的信息。简单地说,就是人工智能为了满足用户的需求而胡编乱造。

虽然听起来是个微不足道的问题,但实际上却是个非常复杂的问题。事实上,我们可能无法完全治愈这种机器 "疾病",这也是许多专家在过去一年中提出的担忧。

图源:Microsoft Bing AI

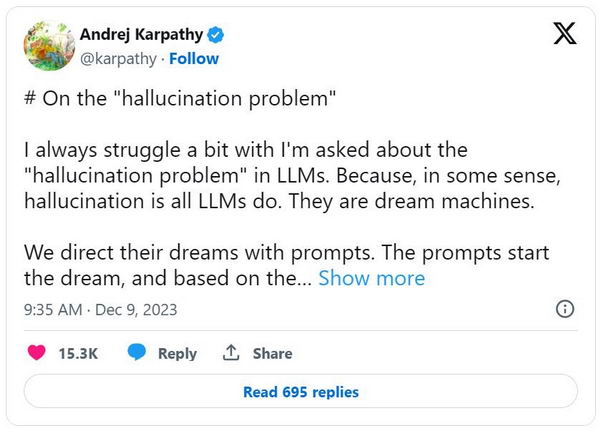

但是,大型语言模型(LLMs)--所有那些流行的生成式人工智能聊天机器人(如必应、Bard 或 ChatGPT)背后的核心技术--真的坏了吗?OpenAI 联合创始人、前特斯拉人工智能高级总监安德烈-卡尔帕西(Andrej Karpathy)的看法恰恰相反。"从某种意义上说,幻觉是 LLM 的全部工作。它们是造梦机器!"他在 X(推特)上发表文章说。

这位出生于斯洛伐克的深度神经网络和自然语言处理专家暗示说,我们用户就是某种导演。我们用自己的提示来启动和引导这个做梦过程,希望能得到有用的结果。

"只有当梦境进入被认为与事实不符的领域时,我们才会给它贴上'幻觉'的标签,"卡尔帕西继续补充道,"它只是看起来像一个错误: 幻觉不是一个错误,它是 LLM 最大的特点。"

与此同时,卡帕奇并不否认人工智能聊天机器人确实存在问题。不过,这里重要的是正确定义问题:

“我意识到,人们‘实际上’的意思是,他们不想让一个 LLM 助理(像 ChatGPT 等产品)产生幻觉。LLM 助理是一个比 LLM 本身更复杂的系统,即使它是它的核心。”

特斯拉自动驾驶开发的前负责人承认,“LLM 助理”有一个问题,我们应该解决。根据 Karpathy 的说法,有几种方法可以解决这个问题,这些都是“活跃的、非常有趣的研究领域”。

要解决问题,首先要意识到问题的存在。现在,自 2022 年生成式人工智能热潮兴起一年多以来,所有研究人员和开发人员都非常清楚地意识到了这个问题。事实上,正是人工智能机器人在商业上的成功推动了这些工具的研究和改进,因为科技巨头们都在争夺最佳消费产品。